- Mitigar el riesgo de extinción de la IA debe ser una prioridad global junto con otros riesgos a escala social como las pandemias y la guerra nuclear.

Declaración sobre el riesgo de IA

Firmado por cientos de expertos, incluyendo los principales laboratorios y científicos de IA

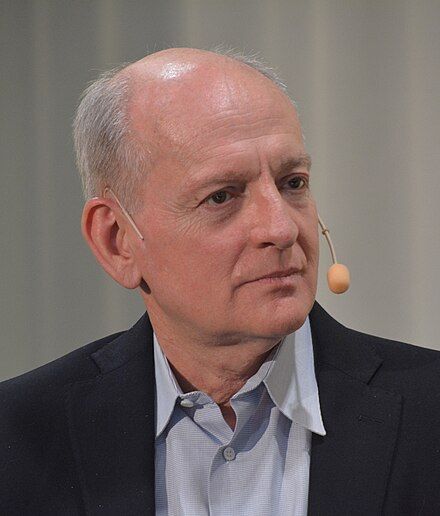

- Si tomas en serio el riesgo existencial, como lo hago yo ahora, podría ser muy sensato dejar de desarrollar estas cosas.

Geoffrey Hinton

Ganador del premio Nobel y 'padre de la IA'

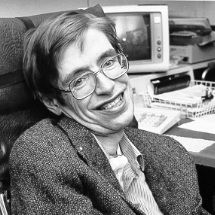

- El desarrollo de la inteligencia artificial completa podría significar el fin de la raza humana.

Stephen Hawking

Físico teórico y cosmólogo

- Eventualmente, deberíamos esperar que las máquinas tomen el control.

Alan Turing

Inventor de la computadora moderna

- Si seguimos [con nuestro enfoque actual], eventualmente perderemos el control sobre las máquinas.

Stuart Russell

Autor del manual de referencia sobre IA

- La IA descontrolada puede ser peligrosa para toda la humanidad. Prohibir los sistemas de IA poderosos (digamos más allá de las capacidades de GPT-4) que se les da autonomía y agencia sería un buen comienzo.

Yoshua Bengio

Ganador del premio Turing de IA

(Top)